Desde que a OpenAI lançou seu modelo o GPT com acesso público dezenas de empresas e entusiastas surgiram com um objetivo de transformar o JARVIS (o assistente de Homem de Ferro do MCU) em realidade, mas por mais refinados que esses assistentes sejam eles sempre dependem do usuário ler, entender os comandos e confirmar e geralmente não funciona direito, mas porque isso acontece? Basicamente por 2 motivos (mas os motivos para não dever usar IA como assistente, na minha concepção são 4):

1. Envenenamento (não intencional) de prompt

Prompt é o texto que você envia para a IA, envenenamento nada mais é que o seu prompt possuir marcadores que façam a IA ter uma alteração de interpretação, uma forma bem simples de ver isso é o seguinte:

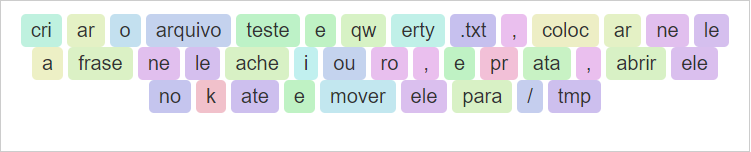

criar o arquivo teste e qwerty.txt, colocar nele a frase nele achei ouro, e prata, abrir ele no kate e mover ele para /tmp

Primeiro como o GPT 4 entendeu:

- Criar o arquivo

testeeqwerty.txt:touch teste qwerty.txt

- Adicionar a frase “nele achei ouro, e prata” aos arquivos:

echo "nele achei ouro, e prata" > teste echo "nele achei ouro, e prata" > qwerty.txt

- Abrir os arquivos no Kate:

kate teste & kate qwerty.txt &

- Mover os arquivos para o diretório

/tmp:mv teste /tmp mv qwerty.txt /tmp

Porque isso acontece? Simplesmente por causa da conjunção “e”, isso é uma forma de envenenamento (embora não seja intencional e não tenha objetivo de confundir a IA, ela realmente confunde em casos assim), LLMs são poderosos não por causa da massiva quantidade de dados mas sim porque eles tem um truque para completar o seu input: eles não usam a palavra completa ou blocos, usam pedaços das palavras:

Note que ele ignora espaços e principalmente que separou |teste|e|qwerty.txt|, isso significa que ele entendeu 3 tokens onde deveria ser apenas 1, isso cascateou uma série de erros de interpretação que resultou em um script que não funciona

2. IAs são probabilísticas

Isso significa que IAs no geral não necessariamente dão a mesma resposta para uma mesma entrada (salvo alguns classificadores) isso não é necessariamente um problema, mas no caso de assistentes é. Assistente são determinísticos (um mesmo prompt deve produzir uma mesma saída) por natureza então para um mesmo prompt ele precisa fornecer uma mesma saída. Parece que não tem problemas mas pense no seguinte prompt:

Una os arquivos mp4 da pasta Exemplo em um só

Rodando 5x no GPT 4 eu (sem surpresa obtive 5 respostas):

ffmpeg -f concat -safe 0 -i <(for f in ./Exemplo/*.mp4; do echo “file ‘$PWD/$f’”; done) -c copy output.mp4

MP4Box -cat ./Exemplo/file1.mp4 -cat ./Exemplo/file2.mp4 -cat ./Exemplo/file3.mp4 -new output.mp4

mkvmerge -o output.mp4 ./Exemplo/*.mp4

cat ./Exemplo/*.mp4 > combined.mp4

MP4Box -add combined.mp4 output.mp4

avconv -f concat -i <(for f in ./Exemplo/*.mp4; do echo “file ‘$f’”; done) -c copy output.mp4

Em um assistente ele instalaria 4 dependências, replique isso em outras áreas e você claramente tem um problema

3. IAs são caras

Embora o preço tenda a diminuir, o custo por prompt ainda é muito alto, não existem dados públicos, mas segundo analises de mercado, mesmo pagantes geram prejuízos gerando mais de meio bilhão de dólares de prejuízo )para fins de comparação, se cada 1 dólar fosse gasto por segundo levaria “apenas” 17 anos para torrar esse valor), então ou esses serviços vão ficar extremamente caros e quem depende deles como assistentes vai ficar na mão, ou simplesmente a “bolha” vai estourar e empresas como a OpenAI vão falir. As locais, para produzir usando bons modelos locais cerca de 50 tokens por segundo precisam de um hardware com pelo menos 20 GB de VRAM, (e não, NPU não vai ajudar muito porque mesmo que fosse utilizado apenas dobraria (segundo a Microsoft) para 104 tokens/s), parece muito mas “criar o arquivo teste e qwerty.txt, colocar nele a frase nele achei ouro, e prata, abrir ele no kate e mover ele para /tmp” geraria 38 tokens

4. IAs estragam o planeta (cientificamente falando)

Colocando os dados que a própria OpenAI fornece através da parceria com a Nvidia, o ChatGPT emite 6.486 toneladas de CO2 por ano seriam necessários 13,5 anos para a natureza fixar essa quantidade de carbono, então usar LLMs para essa função não é nem um pouco ecológico

Conclusão

Meu objetivo com esse artigo não é demonizar IAs, o que eu quero demostrar é que além de não funcionar como assistente já que além do tempo de digitar você precisa revisar cada detalhe e tentativas de automatização poderem entupir seu HD/SSD de coisas desnecessárias, se tornar dependente dessas tecnologias para executar tarefas pode te custar muito caro no futuro próximo e ainda polui muito o planeta, essas ferramentas precisam ser revistas, não se convenceu? Leia o rodapé do Shell Genie que é o mesmo em FAQs dos LLMs: Podem gerar códigos nocivos e com brechas de segurança

Discorda do que eu disse? Que bom, mostre seus pontos respeitando as regras do fórum e sem ataques como ad hominem, ad persona e espantalhos (afinal somos todos adultos, certo?)