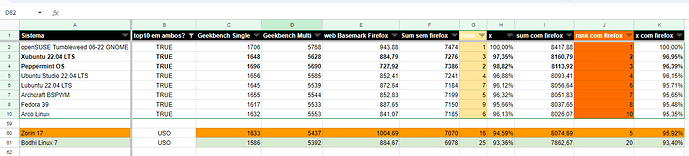

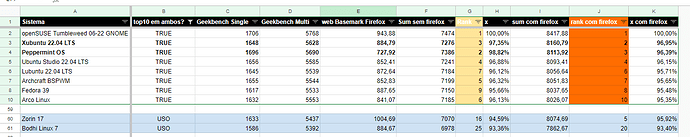

Acesse a planilha com todos os benchmark dos sistemas operacionais que apareceram em nossos reviews!

Legal, mas tenho duas sugestões.

- Coloquem em ordem crescente / decrescente as pontuações.

Isso faz com que a interpretação seja instantânea, sem ter que ficar procurando no gráfico.

- Alterne as cores das barras horizontais

Quando várias barras de mesma cor estão juntas, fica meio complicado de você ter que seguir do nome da distro até a pontuação. Com uma alternância de cores, fica mais fácil guiar os olhos.

Eu escolhi meu sistema linux baseado nessa planilha, mesmo porque eu queria a melhor distro pra utilizar em um hardware antigo que vem sobrevivendo por pura teimosia.

Existe uma outra coisa que pode ser feita pra facilitar a interpretação e ir direto ao ponto, que foi e é o que eu faço: normalizar os dados para que todas as avaliações não ultrapassem os valores entre 0 e 1 e no fim uma coluna com a soma ou a média dessas pontuações ordenado em ordem decrescente ou crescente como na dica do @Passarinho_Azul.

Spoiler: já faz tempo que o openSUSE Tumbleweed fica em primeiro, mas cada um tem sua necessidade, acrescentar um “peso” para cada teste, complica um pouco mais a análise, mas pode ajuda a escolher a melhor distro para necessidades diferentes.

A avaliação que eu fiz esta aqui

obs1: testes não realizados ou que não pontuaram foram considerados como ZERO.

obs2: todos os valores foram considerados que quanto maior melhor conforme os gráficos

será q seria proveitoso roadar um language benchmark também nas distros… pelo menos pras mais usadas/com mais vagas no mercado tipo, java, phyton, js, rust e colocar isso na planilha?

ajudaria a responder a pergunta de melhor distro pra programar em relação a performace

apesar de pra ser sincero n sei se vai fazer diferença entre distros na mesma máquina… vcs vão ser melhores do q eu pra responder isso

uma coisa q gosto muito dessa planilha pra pensar na distro q vou pensar é que eu refaço o ranking sempre… pq eu faço uma cópia e excluo as colunas que n me interessam e deixo praticamente os geekbench e o do firefox pra re-rankear pensando que deve provavaelmente abranger mais o uso do dia a dia nesses testes já q n jogo no linux(desconsiderando android xD)

hj por exemplo eu uso o zorin 17 por n ter me adaptado ao suse

apesar de ser o teste do firefox q ta subindo muito ele nos rankings

@Dio uma sugestão pra planilha pra ajudar a segmentar

sei q a maioria delas se propoe a ser desktop/uso geral mas… algumas são pra ser friendly user, outras pra ser gamer e etc…

será q seria util colocar uma coluna que filtre isso?

“propósito” ou ''proposta" com gamer, user friendly, desenvolvimento, edição de conteúdo

assim além do ranking geral teria um ranking vs as distros que tem a mesma proposta

É uma ideia interessante, mas é difícil dizer se esses filtros, devido aos testes que fizemos, fariam muito sentido.

Eu acabei deixando de fazer esses testes e abastecer essa planilha porque estavam ficando muito pouco consistentes, os primeiros 6 meses eram bem significativos, um ano depois as comparações já eram muito menos justas, e daí por diante ficou ainda mais pobre como referencial.

Um projeto que eu tenho a intenção de fazer em breve vai comparar todas as grandes distros de uma única vez, no mesmo período, ao invés de comparar edições antigas.

Vai dar MUITO trabalho fazer, porque quero ampliar os testes que serão feitos também, mas a intenção é fazer uma ou duas vezes por ano no máximo, e usando hardwares AMD, Intel e NVIDIA em cada distros, para pegar um retrato mais realista do momento.

Deve sair nos próximos meses, e até lá, talvez a gente consiga pensar em formas legais de mostrar esses dados ![]()

é um bom ponto isso do tempo

vou aguardar ansioso por esses updates ![]()

Fazem apesar de ser um indicador qualitativo em um indicador quantitativo, funciona como um filtro

Isso pode levar a outra planilha: uma que avalia o quão user friendly o sistema é o que casa perfeitamente com:

@Dio tem que atualizar os dados do speedometer com nova versão dele.

Vamos ver se entendi:

Você estava comparando testes feitos ao longo de 6 meses, 12 meses?

Se foi isso, então, realmente é melhor fazer comparações, em um único momento, igual para todas as distros / testes.

Distros podem mudar muito, em 6 meses. – Vejo apenas coisas simples, como tempo de boot, uso inicial de RAM etc. – mas isto sugere que outras coisas menos óbvias também podem mudar muito, em 6 meses.

Não exatamente, eu simplesmente testava o sistema, e adicionava ele a planilha, sem muita regra. A intenção nunca foi comparar em um certo período, nem nada, por isso eu sempre colocava a data de quando foi feito o teste, assim as pessoas poderiam ter um melhor contexto.

Em edições mais recentes, a gente passou a considerar somente a distro em teste e o melhor e pior resultados já conseguidos em um determinado benchmark para entender em que posição aquela pontuação ficaria, se mais próximo do melhor, ou mais próximo do pior.

A parte mais interessante é comparar duas versões diferentes do mesmo sistema lançadas em momentos diferentes e comparar a evolução do lançamento. Tipo um Fedora 39 e um 40.

Os dados são bem interessante e bem úteis, mas percebi que as pessoas não estavam sabendo interpretar eles direito, achando que o valor que estava na planilha representava a situação atual do sistema, como se a planilha fosse se atualizando ao longo do tempo on the fly com os updates em mais de 40 sistemas diferentes.

Como não é o caso, decidi parar de fazer os testes dessa forma, estava dando uma noção errada das coisas.

Um Arch testado hoje, e um Arch testado mês que vem pode gerar resultados diferentes, e na planilha, ele ficaria obviamente congelado no tempo em que foi testado pela última vez, mesmo que a data estivesse lá, isso não impedia as pessoas de pensarem que aquele era “o desenho do Arch”, sabe?

Não dá pra culpar quem não consegue interpretar os dados, o negócio é fazer eles ficarem mais claros.

Pros mais atentos, tem muitas deduções interessantes que dá pra fazer a partir desses dados, como a diferença pequena entre as distros mesmo em épocas diferentes para certos testes, reforçando a ideia de “tanto faz”, mas em outros testes, que são mais sensíveis a certos updates, como drivers e kernel, a história é diferente.

Como eu disse, os dados são muito legais e até úteis, mas eles não estavam cumprindo mais o propósito que eu tinha com eles quando comecei a fazer os benchmarks, então decidi parar de seguir aquele caminho.

Possivelmente a próxima comparação de benchmarks que faremos será mais completa e mais complexa também.

Para você ter uma ideia, para testar as 20 distros, discutivelmente, mais famosas, em 7 categorias diferentes, serão necessários 1260 testes, ainda não tive coragem de começar, mas uma hora vai ![]()

Foi o que imaginei:

Também concordo 100% com isso:

A cada ano que passa, as pessoas têm cada vez menos tempo, para ler todos os detalhes, com toda atenção.

A tarefa torna-se cada vez mais “pesada”.

Eu não faço nem 0,1% dessas coisas que você faz – minhas anotações são muito simples – e mesmo assim, faço cada vez menos frequentemente, pelo tempo exigido.

A única sugestão que eu poderia dar, é de atualizar as distros envolvidas, digamos, num Domingo – e tomar aquela data como “a data” – mesmo que os testes tenham de se prolongar por 1 semana, 2 semanas etc.

O “corte temporal” fica sendo a data em que todas as distros envolvidas foram atualizadas – desde que você não as atualize novamente, até terminar todos os testes.

Eu digo “Domingo”, porque já é um “corte” natural: – Um momento de pausa, para a grande maioria dos mantenedores de distros, pelo menos no assim chamado “Ocidente” – embora já tenha visto exceções.

Isso seria incrível, Dio.